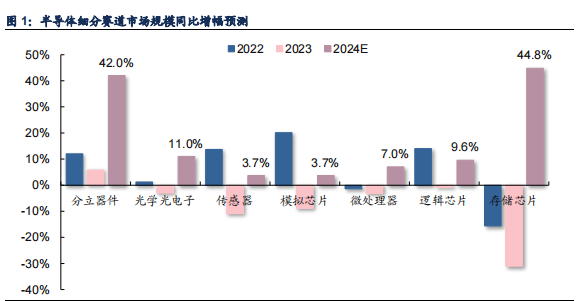

根据 WSTS 预测,2024年存储芯片市场同比将增长 44.8%,增幅居于半导体细分领域之首。

单机容量提升显著,AI 服务器、AI PC 和 AI 手机对存储需求扩大。存储芯片的需求量增长体现在设备出货增长和单机容量提升两个方面,2024 年智能手机、服务器和 PC 出货量均有个位数百分比提升,而单机容量提升或将成为存储市场比特出货的主要驱动。2024 年存储价格有望逐季增长。

DRAM 和 NANDFlash 合约价格分别从 4Q23 和 3Q23 起涨,根据 TrendForce 预测,在需求恢复驱动下,DRAM 和 NAND Flash 四个季度价格或持续增长。

涨价效应持续显现,存储模组厂 Q1 有望淡季不淡。随着DRAM/NAND Flash 合约价继续上扬,客户备货意愿提升。从中国台湾模组厂商 1 月营收数据看,威刚环比+13%/同比+64%,创见环比+16%/同比+37%,宜鼎环比+11%/同比+10%,广颖环比+12%/同比+20%,反映价格上涨、客户补货意愿较强。尽管一季度是消费电子 传统淡季,模组厂仍具备量价提升动能,有望淡季不淡。

相较于半导体其他细分领域,存储芯片市场的弹性更大,这主要是因为存储芯片产品具备科技大宗商品属性,受供求关系影响更为显著。市场下行通道下,原厂开启减产策略以清除库存,同时伴随着下游终端客户需求逐步回暖、库存消耗带来的补库需求,4Q23 存储芯片价格触底反弹。我们认为,2024 年市场需求或将持续恢复好转,同时原厂投产策略仍保持谨慎,在传统需求复苏和新需求刺激作用下,存储市场预计量价均有大幅提升。根据 WSTS预测,2024年存储芯片市场同比将增长 44.8%,增幅居于半导体细分领域之首。

单机容量提升显著,AI 服务器、AI PC 和 AI 手机对存储需求扩大。

存储芯片的需求量增长体现在设备出货增长和单机容量提升两个方面,我们认为,2024 年智能手机、服务器和 PC 出货量均有个位数百分比提升,而单机容量提升或将成为存储市场比特出货的主要驱动。以 PC 为例,SK 海力士表示 AI PC 对存储容量的需求超过两倍。根据TrendForce 预 测 ,2024 年 智 能 手 机/服务器/笔 电 单 机 DRAM 容 量 增 长 分 别 为14.1%/17.3%/12.4%,NAND Flash 容量增长分别为 9.3%/13.2%/9.7%。

2024 年存储价格有望逐季增长。

DRAM 和 NAND Flash 合约价格分别从 4Q23和 3Q23 起涨,根据 TrendForce 预测,1Q24 DRAM 合约价季涨幅约 13%~18%,NANDFlash 则是 18%~23%。DRAM 与 NAND Flash 供应商在 4Q23 下旬和 1Q24 调升稼动率,同时 NAND Flash 买方也早在第一季度将陆续完成库存回补,因此 2Q24 合约价季涨幅预计皆收敛至 3%~8%。3Q24 进入传统旺季,需求端预期来自北美 CSP 的补货动能较强,在稼动率均尚未恢复至满载前提下,DRAM 与 NAND Flash 的合约价有机会扩大至8%~13%,其中 DRAM 因 DDR5 和 HBM 渗透率提升,受惠于 ASP 提高,有望带动涨幅扩大。4Q24 在供应商维持有效控产策略的前提下,涨价或将持续,预计 DRAM 合约价季涨幅约 8%~13%,NAND Flash 则是 0%~5%。

HBM 和 DDR5 需求旺盛,利基存储或间接受益

2024 年存储市场复苏有着一致的预期,但在传统存储产品的投产上仍然保持谨慎,而将投资和产能主要转向 HBM 和 DDR5 的生产。我们认为这反映了(1)HBM 和 DDR5 盈利性更强,原厂更愿意通过高附加值产品来快速增长业绩;(2)来自 AI 的需求,尤其是 AI 服务器的需求仍然强劲,HBM 和 DDR5 的渗透率有望快速提升;(3)当前产能未能满足客户需求,1beta 制程良率仍在提升。在 HBM 和 DDR5 成为原厂投资首要选择下,利基型存储供给有 望保持紧缩,伴随需求的逐步恢复,供需情况有望加速转好。

HBM(High Bandwidth Memory)是三星、AMD 和 SK 海力士发起的一种基于 3D 堆栈工艺的高性能 DRAM,通过增加带宽,扩展内存容量,让更大的模型,更多的参数留在离核心计算更近的地方,从而减少内存和存储解决方案带来的延迟,适用于高存储器带宽需求的应用场合。从技术角度看,HBM 使 DRAM 从传统 2D 转变为立体 3D,充分利用空间、缩小面积,契合半导体行业小型化、集成化的发展趋势。HBM 首先将 DRAM die 堆叠起来,然后利用 TSV技术,在 DRAM芯片上搭上数千个细微孔并通过垂直贯通的电极连接上下芯片。凭借TSV方式,HBM大幅提高了容量和数据传输速率。堆叠好的DRAM die会与GPU一起封装,通过硅中介层里的触线实现连接,最后在底层打上封装基板。以 NVIDIA H100为例,一颗 GPU 需要 80GB 显存,因此在 GPU 附近会放置 5 颗 HBM2E/3。

关注我们:请关注一下我们的微信公众号:扫描二维码

,公众号:betacj

,公众号:betacj版权声明:本文为原创文章,版权归 老杨 所有,欢迎分享本文,转载请保留出处!